Décrypter l’Identification des Goulots d’Étranglement : Stratégies pour Optimiser la Pile Technologique

Introduction : L’Énigme des Goulots d’Étranglement

Dans le monde en constante évolution de la technologie, l’efficacité est une priorité. Les goulots d’étranglement au sein des piles technologiques peuvent freiner les progrès, entraînant un gaspillage de ressources et des utilisateurs frustrés. Identifier et résoudre ces goulots d’étranglement est crucial non seulement pour optimiser les performances mais aussi pour minimiser les coûts et l’utilisation d’énergie. Cet article explore l’approche à plusieurs niveaux pour l’identification des goulots d’étranglement, en s’appuyant sur les stratégies suggérées dans le “Benchmarking and Optimization Playbook” de 2026, notamment concernant les approches “Fuite”. En décryptant les complexités des piles technologiques, les organisations peuvent transformer ces goulots d’étranglement, de barrières invisibles, en opportunités de croissance et d’amélioration.

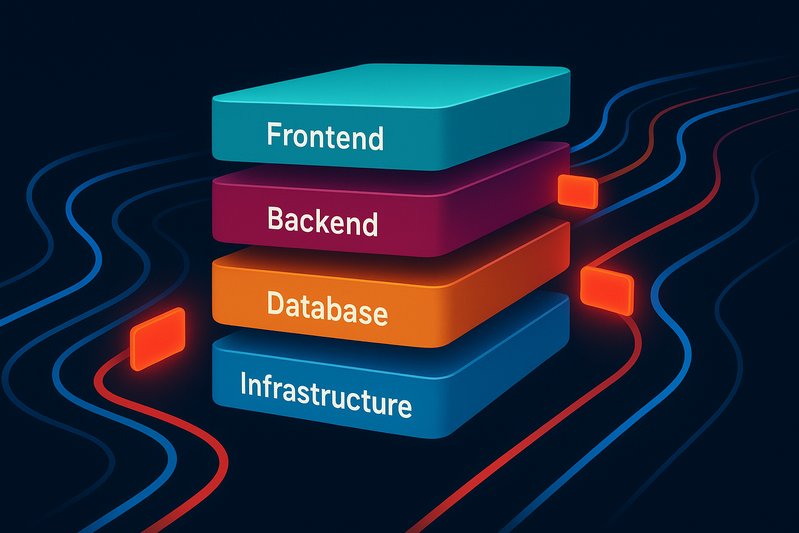

Comprendre les Couches : Où se Cachent les Goulots d’Étranglement

Le Playbook de 2026 propose un cadre complet pour identifier et résoudre les goulots d’étranglement à travers les différentes couches de la pile technologique, chaque couche apportant ses propres défis.

Algorithmes et Structures de Données

À la base de toute pile se trouve l’algorithme. Des structures de données inefficaces ou des choix algorithmiques médiocres peuvent conduire à des blocages élevés de type Instruction Par Cycle (IPC) et à des erreurs de cache. L’utilisation d’outils comme les flame graphs pour visualiser ces points chauds est cruciale. Des améliorations telles que le changement de structures de données ou l’adoption de la vectorisation peuvent améliorer considérablement les performances. Le playbook met l’accent sur l’élimination de la sérialisation redondante et promeut les voies sans copie [19].

Runtime/VM/GC

Pour les langages de haut niveau, le choix du runtime et des ramasse-miettes influence considérablement les performances. Le Playbook recommande d’expérimenter des ramasse-miettes modernes comme ZGC ou Shenandoah pour les applications JVM, et d’utiliser des outils comme le pprof de Go pour profiler afin de repérer les points chauds d’allocation [24]. Adapter ces réglages pour minimiser les temps de pause peut atténuer les goulets d’étranglement liés à la gestion de la mémoire.

Synchronisation et Ordonnancement

La contention des verrous est une source familière de goulots d’étranglement, surtout dans les applications multi-thread. Des temps d’attente élevés pour les verrous de mutex, comme indiqué par les attentes futex, peuvent étranglement un système. Affiner les primitives de synchronisation, choisir des conceptions sans verrou lorsque c’est possible, et optimiser l’ordonnancement des threads sont essentiels pour atténuer ces problèmes [51,52].

E/S et Stockage

Avec l’augmentation des demandes en E/S, réduire la latence dans ce domaine est primordial. Le Playbook suggère de privilégier les interfaces modernes comme io_uring pour ses avantages asynchrones et ses frais généraux réduits. Tester les solutions de stockage avec des outils comme fio aide à s’assurer que les configurations sont optimisées pour la charge de travail [25].

Réseau et Transport

La couche réseau peut également connaître des goulots d’étranglement en raison d’un mauvais contrôle de la congestion ou de retransmissions excessives. En ajustant les contrôles de congestion comme CUBIC ou BBR, et en examinant les protocoles de transport via des outils comme iperf3, les organisations peuvent affiner leurs systèmes pour gérer des charges accrues sans perte d’efficacité [15,28].

Benchmarking et Au-Delà : Optimiser la “Fuite”

Le Playbook détaille une approche structurée pour clarifier et établir des benchmarks pour des types spécifiques de “fuites” logicielles - des problèmes courants pouvant se manifester sous forme de fuites de ressources, d’informations ou de pipelines de données. En standardisant les charges de travail et en utilisant des ensembles de données robustes, le Playbook facilite la réplication des tests et les comparaisons entre différents environnements [9].

Clé de ce processus est de s’assurer que les benchmarks ne reflètent pas seulement des conditions idéales mais des scénarios d’utilisation réalistes. L’utilisation d’outils tels que wrk2 et HdrHistogram permet aux organisations de maintenir une grande fidélité dans les mesures de latence, s’assurant qu’elles capturent efficacement la latence de queue [2][3].

Exploiter les Outils Modernes

La boîte à outils complète recommandée inclut des outils open-source et standards de l’industrie conçus pour 2026 et au-delà.

- Générateurs de Charge : Utilisez des outils comme k6 pour des tests distribués et une génération de charge cohérente et prévisible [4].

- Surveillance des Ressources : Implémentez OpenTelemetry pour des métriques et traçages unifiés à travers les applications, ce qui aide à identifier les goulots d’étranglement avec plus de précision [16].

- Profilage Continu : Des outils comme Parca offrent un profilage continu pour détecter les tendances de performance à long terme et les fuites subtiles qui ne se manifestent que sur de longues périodes [53].

Conclusion : Tracer la Voie à Suivre

Optimiser des piles technologiques pour des performances optimales est comme ajuster un système complexe ; cela nécessite une compréhension claire du rôle de chaque composant et de son interaction au sein du cadre plus large. Le Playbook de 2026 fournit une feuille de route minutieusement recherchée qui illustre non seulement l’identification des potentiels goulots d’étranglement mais aussi leur résolution par des stratégies prioritaires. En appliquant ces idées stratifiées, les organisations peuvent s’assurer que leurs piles technologiques fonctionnent à une efficacité maximale, traduisant efficacement une expertise technique en résultats commerciaux tangibles.

En fin de compte, la capacité à diagnostiquer et atténuer les goulots d’étranglement est indispensable dans le cycle de vie du développement logiciel. Alors que nous avançons vers des besoins computationnels plus sophistiqués et exigeants, ces méthodologies permettront aux équipes techniques de mieux contrôler leurs environnements, garantissant résilience, évolutivité et durabilité.